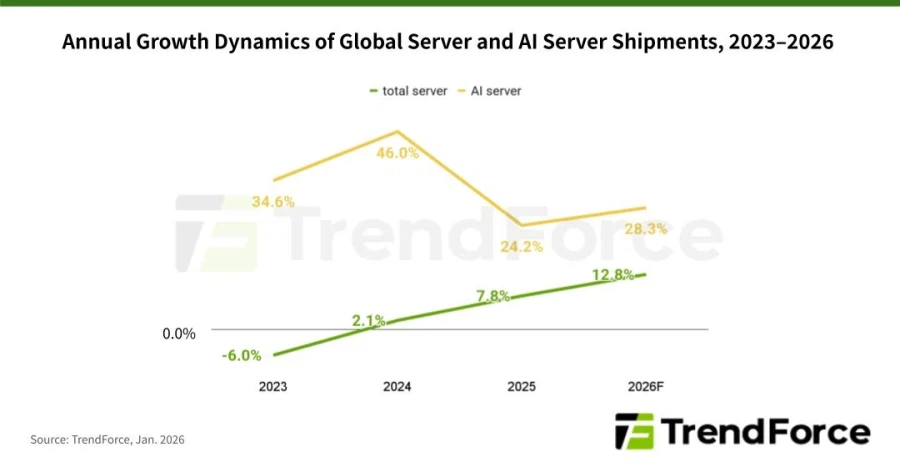

-2026년 전 세계 서버 출하량은 전년 대비 12.8% 증가할 것으로 예상되며, AI 서버 출하량은 전년 대비 28% 이상 급증할 것으로 예상됩니다

-Google과 MS는 증가하는 추론 워크로드를 충족하기 위해 범용 서버 조달을 강화할 예정입니다

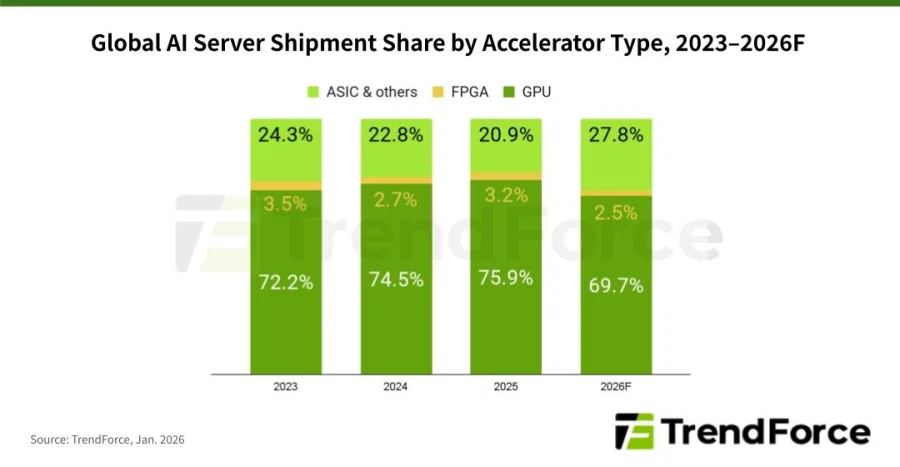

-ASIC 기반 AI 서버는 출하량의 거의 28%를 차지할 것으로 예상되며, 다년간의 정점을 찍을 것으로 예상됩니다.

TrendForce의 최신 시장 조사에 따르면 북미 CSP의 AI 인프라에 대한 지속적인 투자로 2026년 전 세계 AI 서버 출하량이 전년 대비 28% 이상 증가할 것으로 예상됩니다. AI 추론 서비스의 급속한 성장은 교체 및 확장 노력을 모두 지원하는 범용 서버에 대한 수요를 증가시키고 있습니다. 따라서 TrendForce는 2025년부터 AI 서버를 포함한 총 글로벌 서버 출하량이 가속화되어 2026년에는 전년 대비 12.8% 성장할 것으로 예상하고 있습니다.

2024년부터 2025년까지의 서버 시장은 주로 고급 대형 언어 모델(LLM)을 훈련하고 GPU와 HBM을 갖춘 AI 서버를 병렬 컴퓨팅에 활용하는 데 중점을 두었습니다. 그러나 2025년 하반기부터 AI 에이전트, LLaMA 기반 애플리케이션, Copilot 업그레이드의 성장으로 CSP는 수익 창출 전략으로서 추론 서비스에 집중하게 되었습니다. 이제 AI 추론 워크로드는 전용 AI 서버 랙뿐만 아니라 추론 전후 컴퓨팅 및 스토리지를 처리하는 범용 서버에도 배포되고 있습니다.

TrendForce 데이터에 따르면 상위 5개 북미 CSP(Google, AWS, Meta, MS, Oracle)의 총 자본 지출은 2026년에 전년 대비 40% 증가할 것으로 예상됩니다. 대규모 인프라 구축 외에도 이 지출의 일부는 2019~2021년 클라우드 투자 호황기에 구매한 범용 서버를 대체하는 데 사용될 예정입니다. Google과 MS는 Copilot과 Gemini 서비스에서 발생하는 대규모 일일 추론 트래픽을 처리하기 위해 범용 서버 조달을 확대하는 데 앞장설 것으로 보입니다.

2026년 AI 서버 시장에서 출하량 증가는 주로 북미 CSP, 정부 주권 클라우드 프로젝트, 대형 CSP의 사내 ASIC 및 엣지 AI 추론 솔루션 개발 증가에서 비롯될 것입니다. GPU는 출하량의 69.7%를 차지하며 여전히 선도적인 카테고리로 남을 것입니다. NVIDIA의 GB300을 사용하는 시스템이 대부분의 출하량을 주도할 것으로 예상되며, VR200 기반 플랫폼은 하반기에 점차 증가할 것입니다.

2026년까지 Google과 Meta 같은 북미 기업들이 자체 ASIC 노력을 확대함에 따라 ASIC 기반 AI 서버의 점유율은 2023년 이후 최고치인 27.8%에 달할 것으로 예상됩니다. ASIC AI 서버의 출하량 증가율도 GPU 기반 시스템의 출하량 증가율을 앞지를 것으로 예상됩니다. 특히 Google은 대부분의 CSP 경쟁사보다 자체 ASIC에 더 많은 투자를 하고 있으며, 선도적인 시장 플레이어가 될 수 있는 위치에 있습니다. Google 클라우드 플랫폼을 지원하는 자사의 TPU는 Anthropic과 같은 외부고객에게 판매되는 것이 점점 증가하고 있습니다.