[{"keyword":"\ube14\ub8e8\uc544\uce74","rank":0},{"keyword":"\ub864","rank":4},{"keyword":"\ud2b8\ub9ad\uceec","rank":-1},{"keyword":"\uba85\uc870","rank":-1},{"keyword":"\uc544\uc774\uc628","rank":-1},{"keyword":"\ubc84\ud29c\ubc84","rank":-1},{"keyword":"\ub9bc\ubc84\uc2a4","rank":0},{"keyword":"\u3147\u3147\u3131","rank":2},{"keyword":"\ub514\uc544","rank":4},{"keyword":"\ub2c8\ucf00","rank":-1},{"keyword":"\uc5d4\ub4dc\ud544\ub4dc","rank":-3},{"keyword":"\ub9d0\ub538","rank":0},{"keyword":"\uc6d0\uc2e0","rank":-2},{"keyword":"\ud398\uc774\ud2b8","rank":0},{"keyword":"\uadfc\uce5c","rank":"new"},{"keyword":"\uc2a4\ud0c0\ub808\uc77c","rank":1},{"keyword":"\uc820\ub808\uc2a4","rank":-1},{"keyword":"\ub514\uc5442","rank":0},{"keyword":"\uc624\ubc84\uc6cc\uce58","rank":"new"},{"keyword":"\uac74\ub2f4","rank":-5},{"keyword":"@","rank":0},{"keyword":"\uc18c\uc804","rank":0}]

(IP보기클릭)211.235.***.***

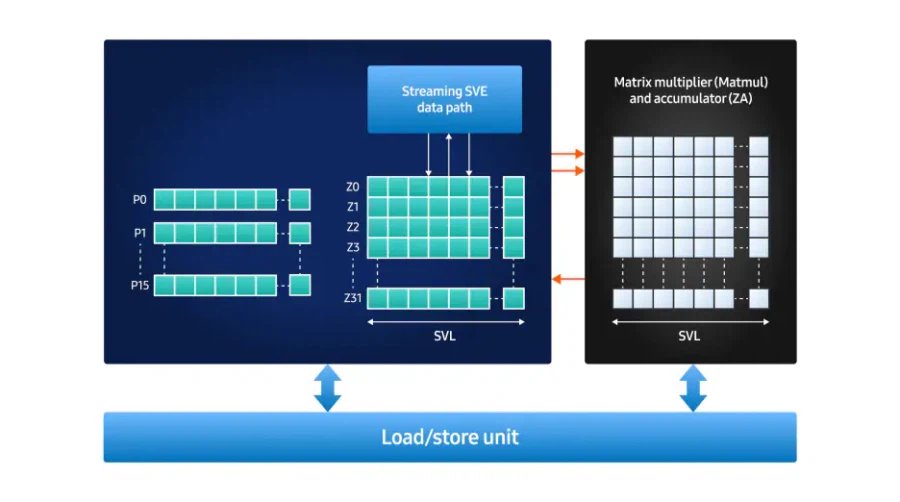

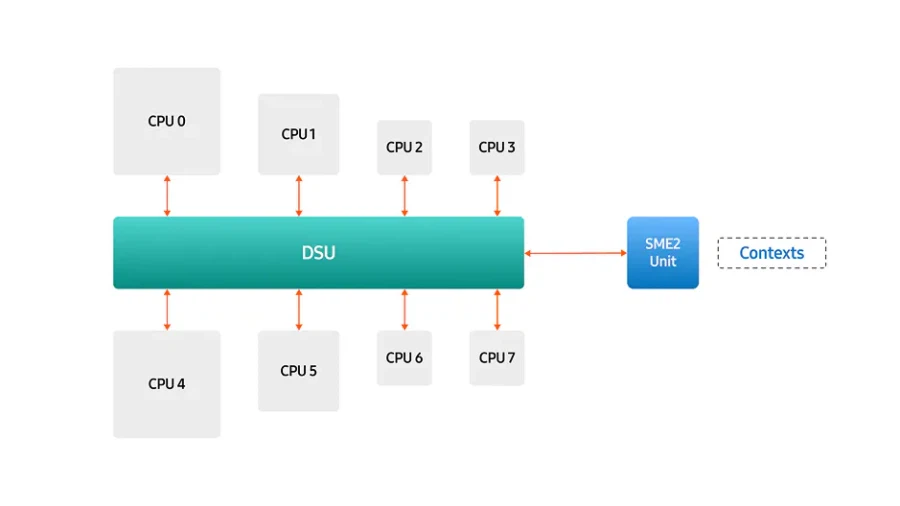

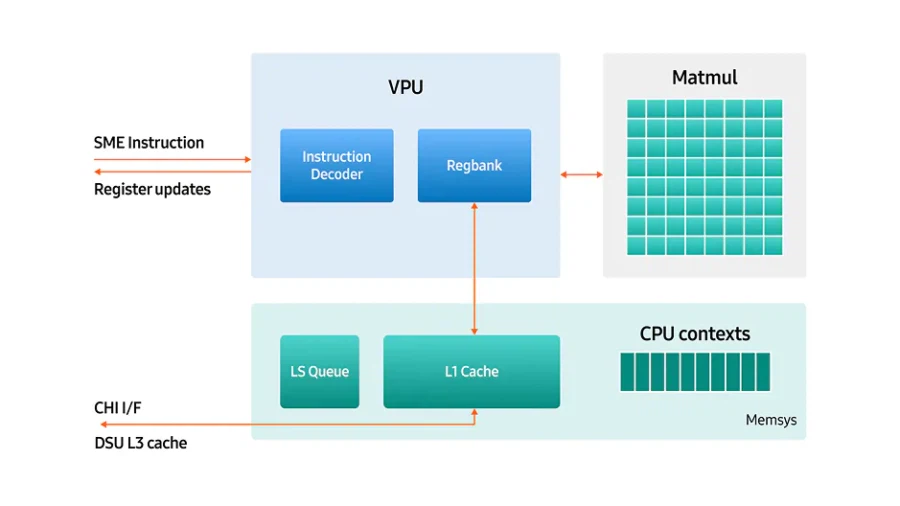

SME2 지원 의미 기존 CPU 아키텍처는 머신러닝 연산에서 요구되는 대규모 병렬 연산을 효율적으로 처리하기에는 구조적인 한계를 지님 이러한 한계를 보완하기 위해 제안된 기술이 SME2(Scalable Matrix Extension 2) SME2는 기존 모바일 CPU의 Arm 명령어 집합에 포함된 확장 ISA¹로, 행렬 연산을 효과적으로 가속할 수 있도록 설계 이를 통해 CPU가 지닌 프로그래밍 유연성을 유지하면서도, 온디바이스 AI에 필요한 연산 성능을 확보할 수 있는 기반이 마련

(IP보기클릭)147.47.***.***

Tensor Core 같은 행렬곱 연산기입니다. 차이점은 systolic array가 아니라 Vector x Vector의 Outer Product 형태로 구성된 유닛이라서 기존 SVE 연산 가속에도 활용가능하다고 합니다.

(IP보기클릭)211.235.***.***

(IP보기클릭)1.237.***.***

(IP보기클릭)14.42.***.***

ai 관련 연산이 cpu 안에서 도니까 지연시간 측면에서도 유리하고, npu 대비 개발환경도 훨씬 범용적일테니. | 26.02.12 19:10 | | |

(IP보기클릭)118.235.***.***

어차피 요즘 ai 연산이 gpu에 통합해서 행렬연산이랑 gpu의 int와 fp병렬자원을 동시에 하는쪽으로 가고 있어서 cpu는 애진작 api실행시켜주는 터미널 역할 수준으로밖에 안쓰거든요. 그래서 그런거죠. | 26.02.12 19:44 | | |

(IP보기클릭)14.42.***.***

대규모 언어모델이면 모를까, 스마트폰이나 PC 수준의 폼팩터에선 절대성능보단 최대한 적은 지연시간과 오버헤드로 즉각적으로 처리해야 하는 경우들이 있으니까요. 그래서 NPU따로 GPU따로 CPU따로 해서 계속 AI연산에 맞게 발전해가고 있는 거. | 26.02.12 19:48 | | |

(IP보기클릭)172.226.***.***

관련 없는 질문이기는 한데요, 왜 이 댓글에 싫어요가 많이 붇는거죠? 잘못된 말도 아닌데다 맥락을 보면 엑시노스를 설계한 삼성 편을 들어주는 것에 가까운데 말이죠.. | 26.02.13 00:12 | | |

(IP보기클릭)14.84.***.***

그걸 구지 느린 cpu쪽에 넣어서 쓰는게 얼마나 효용성이 있느냐의 의문이죠. 이게 데스크톱처럼 pci 인터페이스를 통해 한번 거치는 구조면 모르겠는데 모바일 ap는 통합 soc로 구동되는거라 cpu에 있는것보단 gpu에 ai 연산을 통합시키는게 이래저래 훨씬 낫거든요. 연산력 차이때문에라도 어차피 gpu를 쓰기도 해야하고 확장성도 gpu가 나으니까요. | 26.02.13 00:15 | | |

(IP보기클릭)14.42.***.***

성능의 문제가 아니라 효율성의 문제임. GPU나 NPU한테 워크로드 맡기기도 전에 정말 신속하게 처리할 경우 CPU 안에서도 ai 연산을 처리할 수 있음. 이런 기조가 arm, x86 할 것 없이 모든 업계에서 이루어지는 중임. 지금 사람들이 죄다 GPU NPU TPU GPU NPU TPU 이러니까 CPU는 뭐 그냥 일만 시키는 무언가로 생각하는 사람들이 많지만, NPU나 GPU같은 별개의 회로로 워크로드를 넘기는 것 조차도 비효율성으로 간주되는 워크로드들이 있을 수 있음. 그런 애들이 CPU 안에서 처리할 때 효용성이 생기는 워크로드들이라는 소리임. 혹은 NPU GPU와 통합적으로 처리를 하되, CPU에서 처리할 수 있는 건 처리하고 그 다음에 본격적으로 프로세스를 돌릴 때 NPU GPU를 활용한다거나. | 26.02.13 00:59 | | |

(IP보기클릭)14.42.***.***

안드정게니까요. 당장 제 닉만 봐도 표정 썩을 네임드 삼성팬들 닉 열거하라고 하면 다섯 손가락 다 채울 수 있을 것 같음. | 26.02.13 01:00 | | |

(IP보기클릭)147.47.***.***

Tensor Core 같은 행렬곱 연산기입니다. 차이점은 systolic array가 아니라 Vector x Vector의 Outer Product 형태로 구성된 유닛이라서 기존 SVE 연산 가속에도 활용가능하다고 합니다.